Belgique

4845 Sart-Lez-Spa

Belgique

BE0845092407

Luxembourg

9999 Wemperhardt

Luxembourg

LU29127163

À l'aube de 2017 et avant de jeter le voile sur l'année écoulée, rappelons-nous les événements majeurs et autres changements qui ont fait de 2016 une année riche en termes de référencement.

Vous le savez, la sphère du référencement est régulièrement en proie aux chamboulements. L'année précédente n'y a pas fait exception. En ces premiers jours de 2017, pourquoi ne pas nous remémorer ensemble les évolutions ayant régi 2016?

Quality Update – 11/01/2016

Le moins que l'on puisse dire, c'est que les premiers jours de l'année précédente furent mouvementés! Face aux diverses variations constatées, la communauté SEO a pensé vivre la mise à jour de Google Penguin dès le 11 janvier.

Après diverses hypothèses et de nombreuses tergiversations, il s'est cependant avéré qu'il n'en était rien. Il s'agissait en fait ni plus ni moins que d'une simple mise à jour de l'algorithme principal.

Mise à jour AdWords – 23/02/2016

Fin février 2016, Google s'est employé à une importante refonte des annonces AdWords. Si nous sommes désormais habitués à voir celles-ci figurer en prémices des résultats naturels, auparavant, rappelons-nous, elles étaient alors visibles à l'extrême droite de la page de recherches et nous apparaissaient sous forme de colonne.

Cette modification a eu un impact sur les taux de clics ainsi que sur les mots-clés ultra compétitifs.

Google Mobile Friendly – 12/05/2016

Annoncé pour le mois de mai courant du mois de mars, il aura fallu attendre quelques semaines supplémentaires avant de pouvoir constater l'avènement de Google Mobile Friendly. Cette modification majeure avait pour but de donner un avantage non négligeable aux sites disposant d'un responsive design.

Google Penguin 4.0 – 23/09/2016

Google Penguin, lancé le 24 avril 2012, a, après de longs mois d'attente, finalement été mis à jour le 23 septembre 2016. Sa version 4.0 fait depuis partie intégrante de l'algorithme de Google, permettant donc un rafraîchissement des données en temps réel, tout en étant plus précis.

2017?

Si l'année 2016 fut marquée par plusieurs changements notables, l'année 2017 devrait, elle aussi, être assez mouvementée. Google a en effet d'ores et déjà annoncé le déploiement futur d'un index spécifique au mobile: Mobile First Index. Le géant des moteurs de recherche a également fait connaître sa volonté de donner davantage de poids aux sites sécurisés.

Alors, prêt pour la suite? 😉

Faut-il désavouer les liens Sitewide et Blogroll? John Mueller a répondu à cette question à l'occasion d'un Hangout la semaine dernière. Inoffensif ou à éviter? Voyons ce qu'en pense le Webmaster Trends Analyst de Google…

Depuis l'arrivée de Penguin 4.0, les inquiétudes vont bon train quant à la qualité des liens créés. La semaine dernière, à l'occasion d'un Hangout donné par John Mueller, la conversation s'est rapidement orientée sur les liens Sitewide et Blogroll. Quant à savoir s'il était préférable de s'en passer ou s'ils étaient tolérés, John Mueller s'est montré rassurant:

In general, if these are normal organic links that are happening that are pointing at your content, then I would just let them be, that's the way the internet works. People link to your content, if your students have blogs and they think this is actually a teacher that knows what he's talking about, then that's a good link, that's not something you need to disavow just because its a site wide link or in a blogroll.

D'après ce dernier, leur position n'influerait donc pas leur qualité.

Retrouvez l'entièreté de cette conversation à partir de 2min12:

« Je ne suis pas au courant de choses folles, mais il y a toujours des changements (de notre côté et sur internet) ». C'est en ces termes que John Mueller, porte-parole SEO de Google, réfute toute mise à jour importante dans le domaine du référencement naturel.

Beaucoup de volatilité…

Cette déclaration intervient en réponse aux interrogations formulées sur Twitter par un webmaster, inquiet de la volatilité de certains outils comme Mozcast, SERP Metrics, Advanced Web Rankings, Accuranker ou encore RankRanger. Malgré tout, l'expert se veut rassurant.

@thebesthostnews @methode To be more direct :), I'm not aware of anything crazy, but there are always changes (on our side & on the web).

— John Mueller (@JohnMu) 11 mai 2016

Quid de l'avis de Gary Illyes ?

Et Gary Illyes, Analyste des tendances chez Google, de confirmer, non sans une pointe d'humour : « C'est probablement de la faute de Docteur Pete », Docteur Pete Meyers étant expert en marketing chez Mozcast, site internet à la naissance de ces inquiétudes.

@thebesthostnews probably @dr_pete‘s fault @JohnMu pic.twitter.com/MZSmLDyC0j

— Gary Illyes (@methode) 11 mai 2016

Pas de Google Panda, Penguin ou autre test majeur à l'horizon, donc (selon Google…).

Les weekends se suivent et se ressemblent dans le domaine du référencement naturel. A l'instar de la semaine passée, il semblerait en effet que des fluctuations importantes aient été détectées dans les résultats de recherche de Google. A l'heure actuelle, il est difficile de savoir à quoi cela correspond mais il semblerait que cela ne soit pas en lien avec Google Penguin 4.0

Lundi dernier, nous rapportions que d'importantes fluctuations au sein des SERP de Google avaient été remarquées aux alentours du 10 janvier. Finalement ce n'était pas Google Penguin 4.0 qui venait d'être lancé mais bien une mise à jour de l'algorithme principal de Google (qui va désormais intégrer Google Panda).

Nouvelle mise à jour Google ce 16 janvier 2016

Cette semaine, une évolution identique semble parcourir les résultats de recherche de Google puisque des variations importantes ont été remarquées au cours du weekend écoulé (le 15 ou le 16 janvier). Plusieurs indicateurs nous laissent penser qu'il s'agit d'une mise à jour importante : les fluctuations remarquées sur les outils de suivi automatique (Algoroo notamment) mais aussi les discussions sur les forums et sur les réseaux sociaux.

Ce n'est vraisemblablement pas Google Penguin 4.0

A l'heure actuelle, dès que des fluctuations sont remarquées au sein des SERP de Google, les webmasters évoquent directement Google Penguin 4.0 mais, encore une fois, il semblerait que ce ne soit pas l'oeuvre du célèbre palmipède. En effet, John Mueller et Gary Illyes ont indiqué (ou sous-entendu) que les fluctuations n'étaient pas en lien avec une mise à jour de Google Penguin (même s'il faut toujours prendre les propos de ces Googlers avec du recul).

Voici la question de Ralf Seybold:

Google testing or #penguinupdate? @dawnieando @JohnMu pic.twitter.com/eZ7gEQhDI7

— Ralf Seybold (@1stSEO) 16 Janvier 2016

Et la réponse de Gary Illyes:

@JohnMu also, « no » to the original question (to the best of my knowledge anyway) @dawnieando @1stSEO

— Gary Illyes (@methode) 16 Janvier 2016

Si les nombreux changements remarqués ce week-end ont suspecté l'arrivée du nouveau Penguin, le mouvement principal proviendrait en fait de Google Panda.

Si les nombreux changements remarqués ce week-end ont suspecté l'arrivée du nouveau Penguin, le mouvement principal proviendrait en fait de Google Panda.

On apprend en effet que Google Panda, l'algorithme de Google qui sélectionne des résultats de qualité pour répondre de manière pertinente aux requêtes des utilisateurs, serait maintenant intégré à l'algorithme principal de Google.

Cette nouveauté est mentionnée par Jennifer Slegg, dans un guide sur Google Panda :

Panda is an algorithm that's applied to sites overall and has become one of our core ranking signals. It measures the quality of a site, which you can read more about in our guidelines. Panda allows Google to take quality into account and adjust ranking accordingly.

Si cette nouvelle peut sembler anodine, elle a réellement son importance. Google Panda étant désormais intégré dans l'algorithme de Google, il ne devrait plus y avoir de mises à jour comme celle de juillet 2015 (Google Panda 4.2) parce que la mise à jour de Panda se déroulera en même temps que celle de l'algorithme principal de Google.

Les sites pourront être évalués en permanence (apparemment, il n'est pas encore question d'une analyse en temps réel) ce qui pourrait avoir un impact considérable sur le classement dans les résultats de recherche.

Et pour ceux qui auraient un doute sur les propos de Jennifer Slegg, ses propos ont été avalisés par Gary Illyes sur Twitter:

Wanna know more about Panda? Of course you do. We answered @jenstar ‘s questions, and the result is brilliant! https://t.co/lKiFcYqajX

— Gary Illyes (@methode) 11 Janvier 2016

Une des priorités du moteur de recherche Google est d'améliorer constamment l'expérience de ses utilisateurs. Pour cela, il utilise toute une série d'algorithmes et de filtres, dans le but de proposer aux internautes les résultats les plus pertinents, le plus rapidement possible.

Pour permettre aux novices du SEO de comprendre ces algorithmes, mais aussi pour offrir une mise à jour aux plus experts, en voici un petit récapitulatif :

- Google Panda permet de proposer aux utilisateurs des résultats de meilleure qualité, avec un contenu pertinent par rapport à leur recherche.

- Conseil : évitez le contenu dupliqué, retravaillez la présentation et l'organisation de votre site pour éviter un taux de rebond trop élevé, et assurez-vous que le contenu de votre site est intéressant pour vos visiteurs.

- Google Penguin a pour objectif de décourager les pratiques non-éthiques en matière de référencement.

- Conseil : évitez l'utilisation frauduleuse de liens (liens achetés, échangés, sans pertinence,…).

- Google Hummingbird (ou Colibri) tente quant à lui d'améliorer encore la pertinence des résultats fournis (principalement pour les requêtes de plusieurs mots-clés (longue traine)) avec une meilleure compréhension de l'intention de l'utilisateur.

- Conseil : adaptez votre contenu et vos mots-clés à des recherches « conversationnelles » formulées en langage naturel.

- Google Pigeon propose aux utilisateurs un résultat plus pertinent et plus précis pour leurs recherches ciblées géographiquement.

- Conseil : n'oubliez pas de mentionner vos références géographiques, et tentez d'accumuler les commentaires positifs de la part de vos clients.

- Google Mobilegeddon a pour but premier de favoriser les sites optimisés pour les appareils mobiles.

- Conseil : assurez-vous que votre site est compatible avec une utilisation mobile.

Pour une description plus complète, nous vous proposons cette infographie, réalisée par Simpli Learn.

Comme vous le savez certainement, Google effectue des dizaines et des centaines de mises à jour chaque année. La plupart d'entre-elles sont d'ailleurs tellement minimes que personne ne les remarque. Mais depuis le 19 novembre, des variations sensibles sont régulièrement remarquées dans les résultats de recherche de Google, notamment ce 10 décembre 2015.

Google avait annoncé il y a quelques jours qu'il ne lancerait pas la mise à jour de Google Penguin 4.0 avant le début de l'année 2016 à cause de la période de Fêtes qui nous tend les bras. Cependant, il semblerait pourtant que le moteur de recherche ait effectué une mise à jour qui se déploie lentement depuis le 19 novembre 2015.

Pour rappel, de nombreux webmasters avaient remarqué des évolutions sensibles dans les SERPs de Google autour du 19 novembre 2015 mais John Mueller avait directement démenti une quelconque mise à jour à annoncer. Voici son tweet d'alors:

@dawnieando @rogala_pro @methode most likely, yes. We make 100s of changes every year. Don't have anything more specific to announce, sorry!

— John Mueller (@JohnMu) 19 Novembre 2015

Une mise à jour qui continue à se déployer ?

La réponse de John Mueller n'a pas suffit à faire abdiquer les spécialistes qui pensent qu'on a ici affaire à une nouvelle mise à jour qui se déploie lentement depuis le 19 novembre. En effet, Glenn Gabe a par exemple démontré sur Twitter qu'il avait remarqué des variations assez nettes sur certains sites web le 19 novembre, le 4 décembre et le 10 décembre:

Et Glenn Gabe ne semble pas être le seul à avoir remarqué des évolutions étranges au sein des résultats de Google ces derniers jours. De nombreux messages postés sur les forums WebmasterWorld et BlackHatWorld font également état de variations sensibles sur Google depuis quelques jours.

Et vous, avez-vous remarqué des changements concernant vos positions sur Google ?

Il semblerait qu'un nombre inhabituel d'actions manuelles soit envoyé depuis le début de la semaine par Google dans le but de pénaliser les sites pratiquant des techniques spammy. Est-ce que Google a détecté un nouveau réseau de liens ?

Depuis le début de la semaine, le nombre de webmasters se plaignant d'avoir reçu une pénalité manuelle de la part de Google semble être en nette augmentation par rapport à ce qu'on a l'habitude de constater. En réalité, il semblerait que cela soit surtout depuis les dernières 48 heures que le nombre d'actions manuelles ait augmenté sensiblement.

Voici quelques exemples de plaintes d'internautes sur les réseaux sociaux et sur les forums:

Seeing more Pure Spam questions in the Google help forums lately. This one was interesting: https://t.co/vfXeYPUXK7

— Marie Haynes (@Marie_Haynes) 8 Décembre 2015

@rustybrick my website is penalized by manual action so how can and how much time it will take to recover — Harish Pareek (Hary) (@harypareek) 9 Décembre 2015

Au sein de forums spécialisés (notamment Google Webmaster Help), on remarque également une hausse du nombre de sujets liés à des actions manuelles ou à des baisses de positionnement sur le moteur de recherche.

Un nouveau réseau de liens a-t-il été pénalisé?

Google Penguin ? Google l'a confirmé au cours de la semaine passée: Google Penguin ne verra pas le jour avant le début de l'année 2016. Sauf changement de dernière minute (ce qui est toujours possible avec Google), on peut donc éliminer la possibilité d'une mise à jour de Google Penguin.

Une autre mise à jour ? Difficile à croire étant donné que Google a prétexté l'approche des vacances pour ne pas mettre à jour Google Penguin 4.0…

Un réseau de liens détecté ? C'est davantage plausible mais il faudra recevoir davantage d'informations pour découvrir de quel réseau de liens il s'agit.

Votre site a reçu une sanction manuelle de la part de Google ? N'hésitez pas à contacter notre agence de référencement afin que nous puissions trouver ensemble les meilleures solutions pour que vous retrouviez votre visibilité sur le moteur de recherche.

Décidément, Google multiplie les erreurs de communication pour le moment. Après avoir fait volte-face concernant la mise à jour Google Penguin 4.0 (annoncée pour la fin d'année puis reportée), le moteur de recherche a publié une série de critères de pertinence pour le classement des listes sur Google My Business avant de les modifier.

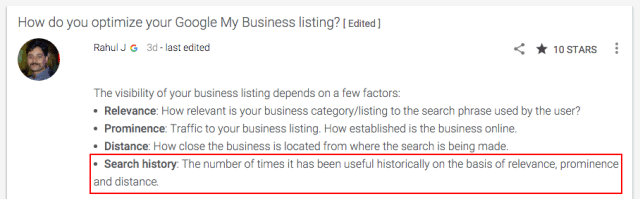

Petit problème de communication la semaine dernière au sein de la maison Google puisque Rahul J (membre de l'équipe Google My Business) a initialement publié une publication concernant le référencement local sur Google+. En effet, ce dernier a publié quatre facteurs de pertinence principaux pour gagner de la visibilité dans les fiches My Business. Il s'agissait de:

- Le pertinence (notamment les catégories utilisées)

- Le trafic sur la fiche

- Le géolocalisation

- Le taux de clics

Petit hic: Google ne s'était jamais prononcé clairement sur le sujet et c'est sans doute pour cette raison que la publication a été modifiée le jour même par Rahul J. Ainsi, plutôt que de parler de « taux de clics » sur la fiche, le Googler explique qu'il s'agit « du nombre de fois où la fiche de l'entreprise a été utile historiquement en fonction de sa pertinence, de son trafic et de sa géolocalisation ». Bref, une nouvelle formulation qui ne fait que reprendre les trois premiers points et qui ne veut pas dire grand-chose au final.

Voici l'évolution de la publication:

AVANT:

APRES:

Conclusion

Comme on s'en doutait depuis longtemps, le taux de clics est bel et bien pris en compte dans l'algorithme local de Google qui permet de classer les fiches Google My Business. Mais Google ne semble toujours pas vouloir communiquer clairement et en toute transparence sur le sujet…

En début de semaine, nous avons appris que Google utilisait un algorithme basé sur des méthodes d'intelligence artificielle et d'apprentissage automatique depuis le début de l'année 2015 dans le but de trier les résultats de recherche en fonction de leur pertinence. Mais que sait-on vraiment de RankBrain ? Voici quelques éléments de réponse.

En début de semaine, nous avons appris que Google utilisait un algorithme basé sur des méthodes d'intelligence artificielle et d'apprentissage automatique depuis le début de l'année 2015 dans le but de trier les résultats de recherche en fonction de leur pertinence. Mais que sait-on vraiment de RankBrain ? Voici quelques éléments de réponse.

Ces éléments de réponse proviennent de Bloomberg (qui a dévoilé l'info) et de SearchEngineLand (qui a reçu des informations en direct de Google).

RankBrain: c'est quoi ?

Concrètement, RankBrain est le nom donné par Google à un système d'intelligence artificielle et d'apprentissage automatique (machine-learning artificial intelligence system). RankBrain est utilisé pour offrir aux internautes des résultats pertinents. Une « très grande proportion » des résultats de recherche sont gérés par RankBrain.

L'apprentissage automatique (machine learning): c'est quoi ?

L'apprentissage automatique désigne un champ d'étude de l'intelligence artificielle qui permet à une machine (un ordinateur par exemple) de s'ordonner lui-même certaines tâches (plutôt que de se les voir demandées par un humain ou en suivant un programme détaillé). Les machines peuvent ainsi accomplir des tâches impossibles à remplir par des moyens algorithmiques plus classiques.

Qu'est-ce que l'intelligence artificielle ?

L'intelligence artificielle (souvent abrégée par I.A.) désigne la capacité d'un ordinateur à être aussi intelligent qu'un être humain (du moins pour acquérir des connaissances, établir de nouvelles connexions, etc.).

En ce qui concerne RankBrain, il semblerait que l'apprentissage automatique et l'intelligence artificielle soient presque synonymes.

RankBrain est-il le nouvel algorithme de recherche de Google ?

Non, RankBrain n'est pas un nouvel algorithme mais s'intègre plutôt dans l'algorithme global du moteur de recherche de Google. L'algorithme de Google s'appelle Hummingbird (nom donné au milieu de l'année 2013 par le moteur de recherche) et permet de trier des milliards de pages en fonction de leur pertinence.

Il semblerait donc que RankBrain fasse désormais partie de l'algorithme général Hummingbird. En effet, l'article de Bloomberg indique clairement que RankBrain ne gère pas toutes les recherches et qu'il ne s'agit que « d'un des signaux inclu dans l'algorithme pour déterminer les résultats qui apparaissent sur le moteur de recherche de Google ainsi que leur positionnement ».

Parmi les autres éléments qui font partie de l'algorithme général Hummingbird, on trouve des filtres antispam bien connus des spécialistes en référencement naturel comme Google Panda, Google Penguin ou Google Payday Loan, des éléments qui ont pour but d'améliorer la pertinence des résultats locaux (Google Pigeon), des éléments qui récompensent les sites mobile-friendly (Google Mobile-Friendly) ou encore des éléments qui visent à lutter contre la violation des droits d'auteur (Google Pirate).

Et le PageRank alors ?

Comme RankBrain, le PageRank fait partie de l'algorithme général de Google. Il s'agit d'un élément qui détermine la pertinence des pages en fonction des liens qui pointent vers elles.

PageRank est certainement l'élément le plus connu de l'algorithme de Google car c'est le premier nom que Google a donné à un élément de son algorithme. Cela date déjà de 1998.

RankBrain: le 3e critère de ranking le plus important ?

Si on en croit l'article de Bloomberg, cette affirmation est exacte. L'article cite Greg Corrado, un ingénieur travaillant chez Google:

« RankBrain is one of the « hundreds » of signals that go into an algorithm that determines what results appear on a Google search page and where they are ranked, Corrado said. In the few months it has been deployed, RankBrain has become the third-most important signal contributing to the result of a search query, he said ».

Conclusion

RankBrain est donc une énième surcouche de l'algorithme principal de Google, mais une surcouche particulièrement importante si on en croit les dires de son ingénieur, Greg Corrado.

Cette surcouche vise à analyser et à comprendre les contenus avec plus de pertinence. Cela peut paraître quelque peu inquiétant, mais cela signifie également que les contenus des sites web seront encore plus importants dans le futur.