Belgique

4845 Sart-Lez-Spa

Belgique

BE0845092407

Luxembourg

9999 Wemperhardt

Luxembourg

LU29127163

Du 21 au 24 octobre se déroulait le salon Pubcon à Las Vegas, un salon où des conférences sur les médias et leur optimisation se concentrent depuis bientôt quinze années (la première édition a eu lieu en 2000). Cette année, Matt Cutts, le chef de l'équipe antispam de Google, n'a pas hésité à parler SEO et spam durant ses interventions. Voici quelques sujets qui ont été abordés.

Du 21 au 24 octobre se déroulait le salon Pubcon à Las Vegas, un salon où des conférences sur les médias et leur optimisation se concentrent depuis bientôt quinze années (la première édition a eu lieu en 2000). Cette année, Matt Cutts, le chef de l'équipe antispam de Google, n'a pas hésité à parler SEO et spam durant ses interventions. Voici quelques sujets qui ont été abordés.

PS : nous ne reprendrons pas ici tous les sujets qui ont été abordés par Matt Cutts mais vous pouvez les retrouver dans cet article de Searchenginewatch.

Hummingbird, Panda et autorship

Dans son intervention, Matt Cutts a affirmé que selon lui, beaucoup de publications de blogs à propos de comment ranker avec Hummingbird n'étaient pas pertinents. Pour Matt Cutts, et contrairement à ce que certains disent, ce nouvel algorithme n'a pas un énorme impact au niveau du SEO. D'ailleurs, personne ne l'a remarqué alors que cela fait plus d'un mois qu'il a été lancé.

A côté de cela, Panda a été adouci ces derniers mois comme l'ami Matt l'avait expliqué au mois de mai, juste avant l'été, ce qui veut dire que certains sites de qualité qui ont été touché par Panda il y a quelques mois pourront éventuellement voir leurs sites retrouver leur places dans les résultats de recherche de Google.

Enfin, Matt Cutts a parlé de de l'authorship. Nous vous en parlions pas plus tard que mercredi dans notre article où nous mettions en avant les pratiques SEO viables sur le long terme : Google cherche a booster l'autorité à travers l'autorship. Durant ce Pubcon, Matt a confirmé que Google se dirigeait vers cette direction et que l'autorship deviendrait de plus en plus important pour la visibilité dans les résultats de recherche.

Enfin, Matt Cutts a parlé de de l'authorship. Nous vous en parlions pas plus tard que mercredi dans notre article où nous mettions en avant les pratiques SEO viables sur le long terme : Google cherche a booster l'autorité à travers l'autorship. Durant ce Pubcon, Matt a confirmé que Google se dirigeait vers cette direction et que l'autorship deviendrait de plus en plus important pour la visibilité dans les résultats de recherche.

Les résultats de recherche du mobile

Matt Cutts a également discuté du rôle des smartphones et de leur impact sur les résultats de recherche en expliquant qu'il s'agit d'un domaine au sein duquel les référenceurs devront faire attention. En effet, le chef Cutts a clarifié la situation en insistant sur le fait que les sites web qui ne seront pas « mobile-friendly » verront un impact négatif sur leur positionnement dans les résultats de recherche sur mobile.

Parmi les éléments qui seront pris en considération selon Matt Cutts, on trouve notamment la question du Flash et de son poids ou encore la vitesse de chargement pour les smartphones.

On ne peut qu'être d'accord avec l'importance qui doit être accordée à la recherche sur mobile qui ne fera qu'augmenter dans les prochaines années.

Penguin et les stratégies de spam

Matt Cutts a déjà parlé beaucoup de ce qu'il fallait faire ou ne pas faire dans sa stratégie de linking dans ses vidéos (sans pour autant être vraiment clair à ce sujet). Au Pubcon, Matt Cutts a expliqué que le travail de Google consistait à éliminer le spam des résultats de recherche de Google et qu'aujourd'hui le moteur de recherche travaillait sur des mots clés assez précis tels que « payday loans » (prêt sur salaire ?), « car insurrance » (assurance voiture), « mesothelioma » (mésothéliome) et des mots clés « porno ».

Matt Cutts a déjà parlé beaucoup de ce qu'il fallait faire ou ne pas faire dans sa stratégie de linking dans ses vidéos (sans pour autant être vraiment clair à ce sujet). Au Pubcon, Matt Cutts a expliqué que le travail de Google consistait à éliminer le spam des résultats de recherche de Google et qu'aujourd'hui le moteur de recherche travaillait sur des mots clés assez précis tels que « payday loans » (prêt sur salaire ?), « car insurrance » (assurance voiture), « mesothelioma » (mésothéliome) et des mots clés « porno ».

La raison de cet « acharnement » sur ces mots clés résulte du fait que ce sont des recherches qui peuvent générer de grosses sommes d'argent, ce qui attire inévitablement les spammeurs. C'est donc pour cette raison que Google tente de travailler sur ces requêtes pour qu'elles soient non-spammées.

Le PageRank

Enfin, concernant le PageRank, Matt Cutts a expliqué que le « pipeline » qui est utilisé pour offrir les données est cassé et Google n'a personne qui travaille dessus pour le réparer actuellement. Autrement dit, les nouvelles ne sont pas bonnes pour les adeptes de cet indice de popularité et de qualité du site.

Il n'y aura donc pas de mise à jour prochaine du PageRank, pas cette année en tout cas. On ne sait d'ailleurs pas dire s'il y aura encore des mises à jour car Google va d'abord analyser l'impact que cela aura de ne pas l'actualiser.

La vidéo complète de ce discours de Matt Cutts ci-dessous :

Si nous avons généralement tendance à débuter la semaine en infographie, nous changeons quelque peu nos habitudes ce lundi puisque, comme certains spécialistes l'avaient pressenti dès vendredi matin (notamment @seof1), Matt Cutts, le chef de l'équipe anti-spam de Google a publié un tweet vendredi 4 octobre dans lequel il annonçait le déploiement de Penguin 2.1 sur le web, ayant pour effet d'impacter environ 1% des requêtes.

Si nous avons généralement tendance à débuter la semaine en infographie, nous changeons quelque peu nos habitudes ce lundi puisque, comme certains spécialistes l'avaient pressenti dès vendredi matin (notamment @seof1), Matt Cutts, le chef de l'équipe anti-spam de Google a publié un tweet vendredi 4 octobre dans lequel il annonçait le déploiement de Penguin 2.1 sur le web, ayant pour effet d'impacter environ 1% des requêtes.

Il s'agit donc de la cinquième mise à jour de Penguin (retrouvez-les toutes ici), un algorithme visant à lutter contre le spam et autres stratégies de netlinking « illicites« .

Voici le tweet que Matt Cutts a publié sur Twitter :

Penguin 2.1 launching today. Affects ~1% of searches to a noticeable degree. More info on Penguin: http://t.co/4YSh4sfZQj

— Matt Cutts (@mattcutts) October 4, 2013

Malheureusement, dans le liens indiqués par Matt Cutts, on retrouve un article datant du mois d'avril 2012, soit le mois du lancement de la première mise à jour de Penguin dans laquelle Google indique aux webmasters l'incidence de Penguin sur certains sites web. Google ne nous donne donc pas énormément d'informations concernant cette nouvelle mise à jour.

Pourquoi Penguin 2.1 ?

Google ne fait décidément rien pour faciliter la compréhension aux internautes peu au fait de ses mises à jour. En effet, au lieu de nommer ses mises à jour de manière croissante (de 1 jusqu'à 65 s'il le faut), Google a décidé d'utiliser une méthode de comptage différente en insérant un « . » pour les mises à jour moins importantes. C'est ainsi que Google a proposé une version de Panda 3.1 au lieu de la version 4 il y a plus de 2 ans maintenant.

Malheureusement, Google n'indique pas toujours s'il s'agit une mise à jour mineure ou majeure. Du coup, beaucoup de spécialistes s'y perdent un peu et ne savent plus vraiment comment nommer les mises à jour de Google.

Si Google a indiqué au moins de mai la mise à jour de Penguin 2.0 (car mise à jour importante), nous continuerons a indiqué aux internautes aussi bien la version officielle de Google (2.1 pour celle du 4 octobre) que la version croissante : Penguin 5.

Quels impacts ?

De notre côté, nous n'avons pas encore vu d'impacts concernant cette nouvelle mise à jour de Google. En avez-vous vu de votre côté ? Vos sites ont-ils perdu en visibilité ? N'hésitez pas à nous en faire part dans les commentaires !

Matt Cutts, chef de l'équipe antispam de Google, revient cette semaine avec une nouvelle vidéo dans laquelle il répond à cette question d'un internaute espagnol :

Matt Cutts, chef de l'équipe antispam de Google, revient cette semaine avec une nouvelle vidéo dans laquelle il répond à cette question d'un internaute espagnol :

Does it make sense to use rel= »nofollow » for internal links ? Like, for example, to link to your login page ? Does it really make a difference ?

En français : Faut-il utiliser l'attribut nofollow pour les pages internes, par exemple pour lier sa page de login ?

A cette question, Matt Cutts répond de manière ambiguë, expliquant qu'on ne devrait pas le faire, même si cela ne risque pas de compromettre la visibilité du site internet en question. En effet, pour Matt Cutts, faire pointer des liens nofollow vers sa page de login ou vers n'importe quelle page qui semble inutile n'aura pas d'impact négatif sur la visibilité ou le référencement du site internet.

Cependant, le chef de l'équipe antispam de Google annonce également dans cette vidéo que, à l'inverse, ne pas ajouter l'attribut nofollow dans ces pages internes n'aura pas non plus d'impact négatif et qu'en général, il est préférable de laisser Google crawler le plus de pages possible de votre site internet.

Enfin, dans la plupart des cas, un attribut noindex sera peut-être préférable à un nofollow sur le lien interne.

Voici la vidéo complète de Matt Cutts :

Que pensez-vous de ce que dit Matt Cutts ? Ne trouvez-vous pas troublant qu'il dise de ne pas mettre d'attribut nofollow quand on sait que Panda pénalise les pages qui apportent peu de contenu ?

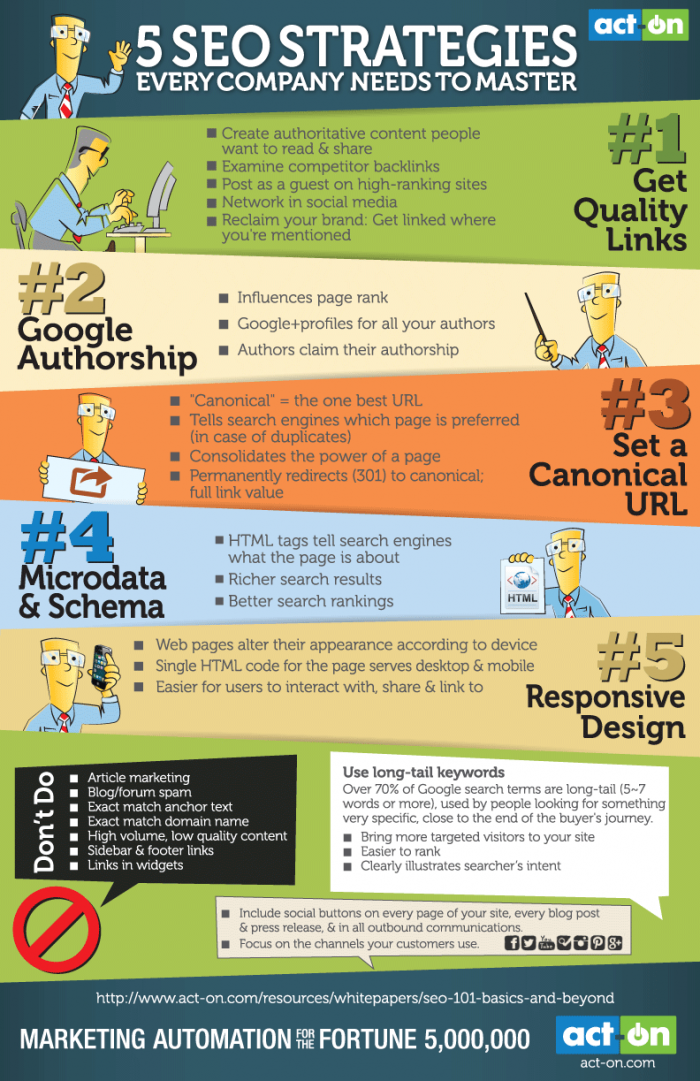

De nos jours, se positionner de manière idéale sur les moteurs de recherche peut avoir une influence considérable sur les ventes et la notoriété d'une entreprise. En effet, se positionner dans les 3 premières positions pour un mot clé spécifique sur Google ou figurer en 3e page n'aura pas le même impact pour l'entreprise.

Pour se positionner le plus haut possible sur les moteurs de recherche, il faut que l'entreprise maîtrise parfaitement les stratégies Search Engine Optimization (SEO ou optimisation pour les moteurs de recherche) ou qu'elle les délègue à une agence de référencement.

Se positionner dans les premiers résultats des moteurs de recherche n'est pas chose facile et ce n'est pas donné à tout le monde. En effet, les techniques de référencement évoluent jours après jours et il faut sans cesse rester à l'affût des dernières actualités et des mises à jours des algorithmes de Google (Panda ou Penguin) pour rester dans la course.

Pour aider les entreprises qui référencent leurs sites par elles-mêmes, Act-On a réalisé une infographie résumant les principales techniques que les entreprises se doivent de maîtriser.

PS: Dans le cas où vous voudriez déléguer votre référencement, n'hésitez pas à nous contacter 😉

Via www.business2community.com

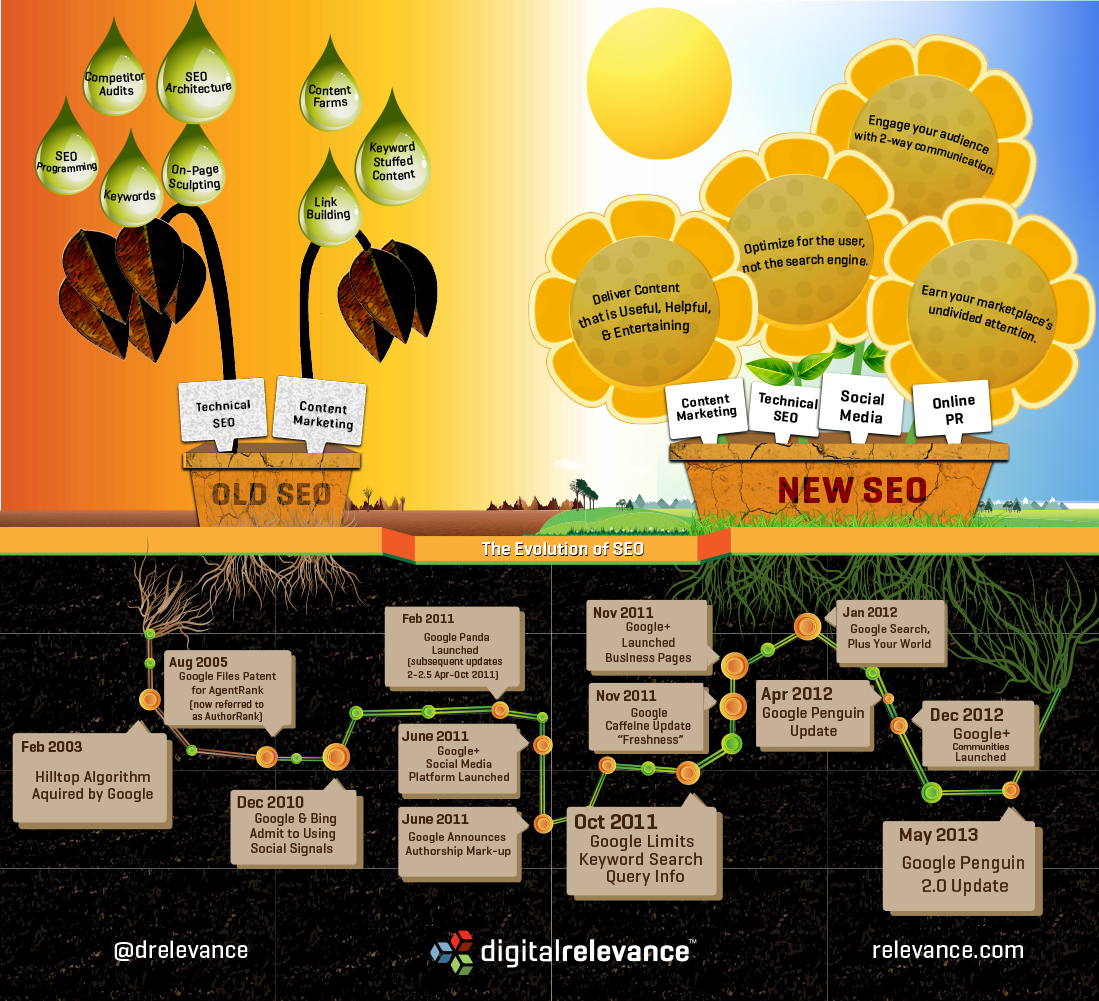

Après la petite interruption de nos actualités pendant le début du mois d'août, nous reprenons petit à petit nos anciennes habitudes. Et comme nous sommes lundi, nous vous proposons une nouvelle infographie concernant le Search Engine Optimization (SEO).

Cette infographie a été réalisée par Relevance.com et relayée ce weekend par Business2community. Comme le SEO a connu une évolution particulièrement dynamique ces 10 dernières années, Relevance.com a repris dans son infographie les dates importantes de cette évolution et a mis en évidence le changement entre l'ancienne version du SEO et les nouvelles pratiques qu'il faut privilégier à l'heure actuelle.

Voici l'infographie en question :

Les dates essentielles du SEO

Parmi les dates importantes figurant dans cette infographie on épinglera :

Février 2003 : Google sort l'Hilltop algorithme. Il sert à trouver les résultats de recherche des sites d'autorité.

Décembre 2010 : Google et Bing commencent à utiliser les réseaux sociaux pour déterminer le positionnement dans les moteurs de recherche. Le SEO commence à évoluer avec l'importance croissante des contenus pertinents et de l'engagement des utilisateurs.

Février 2011 : Google lance une mise à jour de Panda visant à éliminer les sites internet de pauvre qualité qui polluent les résultats des moteurs de recherche.

Avril 2012 : Google lance Google Penguin, une mise à jour ayant pour principal objectif de pénaliser les liens provenant de sites web de faible qualité

Dans une nouvelle vidéo publiée hier sur Youtube, Matt Cutts tente d'expliquer trois thèmes parmi les idées fausses provenant de l'industrie du SEO. En 5 minutes, le chef de l'équipe anti-spam de Google explique :

Dans une nouvelle vidéo publiée hier sur Youtube, Matt Cutts tente d'expliquer trois thèmes parmi les idées fausses provenant de l'industrie du SEO. En 5 minutes, le chef de l'équipe anti-spam de Google explique :

- Que les référenceurs confondent souvent les mises à jour des algorithmes avec le rafraîchissement de données;

- Que les algorithmes Panda et Penguin n'ont pas vocation de faire rentrer plus d'argent dans les caisses de Google;

- Et enfin que les référenceurs se centrent trop sur la stratégie de linkbuilding et sur les moteurs de recherche.

Algorithmes et mises à jour :

La principale différence entre une mise à jour de l'algorithme et un rafraîchissement des données de celui-ci consiste dans le fait que lorsque Google effectue une mise à jour, cela influence la manière dont les résultats sont classés, filtrés et indexés. A l'inverse, le rafraîchissement des données met simplement les données à jour.

Matt Cutts nous offre un exemple : Penguin 2 et 3 étaient des rafraîchissements de données tandis que Penguin 4 (ou Penguin 2.0) était une mise à jour.

Les gains de Google via Panda et Penguin :

Beaucoup de personnes pensent que Panda et Penguin n'existent que pour augmenter les revenus de Google. Cependant, Matt Cutts tient à clarifier cela en précisant que les algorithmes et les résultats de recherche organique sont séparés au niveau des revenus. Au contraire, Matt Cutts explique que Panda peut avoir des conséquences négatives sur les bénéfices de Google car son objectif est de faire disparaître les contenus de faibles qualité. Or ces sites sont principalement monétisés par les revenus AdSense.

Les référenceurs se concentrent trop sur le link-building

Ce n'est pas la première fois que Matt Cutts utilise ce genre de discours : les référenceurs se concentrent trop sur le link-building et sur le moteur de recherche au lieu de travailler pour l'utilisateur. Pour lui, les grands sites se basent avant tout sur l'expérience de l'utilisateur car plus ce dernier est content, plus il le recommandera à d'autres utilisateurs.

Voici la vidéo complète de Matt Cutts : « What are some misconceptions in the SEO industry ? »

Merci à Abondance et à Searchengineland

Matt Cutts a publié une nouvelle vidéo hier après-midi. Dans cette dernière, le chef de la recherche anti-spam de Google répond à certaines questions que se posent webmasters et référenceurs quant à l'avenir du référencement. Plus précisément, la question à laquelle Matt Cutts a répondu était:

Matt Cutts a publié une nouvelle vidéo hier après-midi. Dans cette dernière, le chef de la recherche anti-spam de Google répond à certaines questions que se posent webmasters et référenceurs quant à l'avenir du référencement. Plus précisément, la question à laquelle Matt Cutts a répondu était:

« What should we expect in the next few months in terms of SEO for Google? »

Dans cette vidéo un peu plus longue qu'à l'accoutumée (7 min 24 avec un t-shirt noir rappelant le logo de Firefox), Matt Cutts dresse 10 points qu'il résume à la fin de la vidéo. 10 points qui devraient permettre d'augmenter les résultats de recherche sur Google en récompensant les bons sites et en pénalisant les mauvais (spammeurs, black hat, etc.). Pour rappel, nous vous indiquions hier que ce même Matt Cutts annonçait une nouvelle version de Penguin pour les prochaines semaines (« Penguin 2.0 sortira dans quelques semaines« , qui est d'ailleurs le premier point énoncé par Matt Cutts).

- La prochaine mise à jour de Penguin va aller plus loin et va avoir plus d'impact que les précédentes.

- Le publireportage risque d'être plus sévèrement combattu par l'équipe anti-spam de Google car ils gonflent artificiellement les profils.

- Les requêtes spam : Google va également se pencher de manière plus radicale sur certaines requêtes dites « spammy », c'est-à-dire des requêtes à tendance pornographiques par exemple.

- Google veut aller plus loin (« upstream ») pour dissuader les spammeurs et pour diminuer la valeur des liens qu'ils acquièrent.

- Une analyse des liens plus sophistiquée : Google est actuellement en train de mettre au point des logiciels beaucoup plus sophistiqués pour analyser les liens.

- Continuer à améliorer la prévention pour les sites piratés : ces derniers temps, Google a beaucoup travaillé pour prévenir les internautes qu'un site pouvait potentiellement avoir été piraté. L'équipe anti-spam de Matt Cutts veut continuer dans cette optique et les enlever des résultats de recherche.

- Booster l'autorité : Google veut donner plus d'autorité aux sites qui sont des références dans leur industrie, dans leur communauté. Cela devrait permettre à ces sites dits « d'autorité » de gagner des places dans le classement des résultats de recherche.

- Adoucissement de Panda : d'après Google, certains sites touchés par Panda sont des cas « limites ». Du coup, Matt Cutts cherche un moyen d'adoucir l'impact de Panda sur certains sites en analysant d'autres qualités afin que ces sites ne soient pas touchés par Panda.

- Les regroupement des URL d'un même nom de domaine dans la première page de résultats : le nombre de noms de domaine identiques figurant sur la première page de résultats devrait être réduit afin de rendre cette page de résultats plus diversifiée. Par contre, une fois sur la deuxième page de résultat, des noms de domaine identiques pourront plus facilement se retrouver.

- Améliorer la communication avec les webmasters : Matt Cutts veut offrir des informations plus détaillées aux webmasters dans le Google Webmaster Tools.

Voici la vidéo complète dans laquelle Matt Cutts énumère ces différents points dans le but d'empêcher le black hat de truster les premières places du résultat de la recherche.

Source : Searchengineland.com

Vendredi passé, Jamie Dodd, un twitto expert en SEO a demandé à Matt Cutts via Twitter s'il pouvait confirmer la mise à jour de Penguin pour le weekend qui vient de s'écouler. Et sa question était légitime puisque Matt Cutts avait annoncé il y a quelques semaines que des mises à jours de Panda et de Penguin allaient bientôt voir le jour.

Vendredi passé, Jamie Dodd, un twitto expert en SEO a demandé à Matt Cutts via Twitter s'il pouvait confirmer la mise à jour de Penguin pour le weekend qui vient de s'écouler. Et sa question était légitime puisque Matt Cutts avait annoncé il y a quelques semaines que des mises à jours de Panda et de Penguin allaient bientôt voir le jour.

Dans sa réponse à la question de Jamie Dodd, Matt Cutts a d'abord expliqué qu'il n'y avait pas eu de mises à jour durant la semaine, avant de préciser qu'il y en aurait certainement une dans les semaines qui viennent. Le chef du département anti-spam de Google a aussi laissé entendre que cette nouvelle mise à jour devrait être plutôt important car l'a appelée Penguin 2.0, « La nouvelle génération de de Penguin ».

Une autre raison pour laquelle il pourrait s'agit d'une mise à jour importante consiste dans le fait qu'il n'y a plus eu de mises à jour de Penguin depuis le 5 octobre 2012, soit près de 8 mois de disette alors qu'il y avait eu trois mises à jour de Penguin durant l'année 2012.

Pour éviter d'être pris dans les griffes de Penguin, nous vous conseillons de suivre quelques conseils que vous trouverez dans le guide pour rester SEO friendly après Penguin.

Merci à Olivier Duffez pour avoir attiré notre attention sur cette information dans son article.

Il y a encore quelques années, les stratégies de référencement utilisées par certaines agences étaient simples car elles consistaient à générer des milliers de liens (spams), à proposer quelques mots clés sur certains sites et à débourser un peu d'argent pour que le mot clé désiré se situe en bonne position « en fin de journée ».

Retour sur l'héritage du spam

Cependant, aujourd'hui, beaucoup de référenceurs ont travaillé afin de faire évoluer leurs pratiques mais il reste encore un certain héritage du spam qu'il faut essayer de nettoyer.

Depuis le début des pratiques en référencement, le spam a été présent. En effet, il y a toujours eu des professionnels qui ont fait du « keywordstuffing », qui ont proposé des commentaires spams sur des blogs, qui ont créés des textes générés par des robots ou qui ont acheté des liens. D'ailleurs, certains référenceurs peu scrupuleux utilisent encore et toujours (malheureusement) ce genre de pratiques, aussi risquées soient-elles.

Cependant, à l'époque, ces techniques étaient efficaces et c'est pour cette raison que certains spécialistes s'y sont engouffrés. Malheureusement, ces techniques ont engendré du spam et ces spécialistes n'en connaissaient pas encore les conséquences.

Google s'est défendu

Avec le recul, on se rend compte que ces pratiques n'étaient pas bonnes. Aujourd'hui, tout référenceur doit avoir compris qu'un bon lien est un lien naturel, pertinent et utile. En d'autres mots, le lien doit améliorer le site internet, ne pas seulement servir les moteurs de recherche, ne pas faire partie d'une série d'ancres sur-optimisées sur des blogs non-pertinents et, enfin, être construit à destination des internautes.

Avec le recul, on se rend compte que ces pratiques n'étaient pas bonnes. Aujourd'hui, tout référenceur doit avoir compris qu'un bon lien est un lien naturel, pertinent et utile. En d'autres mots, le lien doit améliorer le site internet, ne pas seulement servir les moteurs de recherche, ne pas faire partie d'une série d'ancres sur-optimisées sur des blogs non-pertinents et, enfin, être construit à destination des internautes.

C'est pour éviter ces pratiques néfastes pour l'expérience de l'utilisateur que Google a d'abord lancé la mise à jour Panda afin de toucher les sites proposant des contenus dupliqués ou à peine changés. Puis il a mis sur pied le filtre Penguin afin de lutter contre le spam et les abus d'ancres identiques dans les articles.

C'est à ce moment-là que les experts du référencement qui pratiquaient le spam ont commencé à penser différemment.

L'évolution du référencement

Après Google Panda et Penguin, les sites qui avaient acheté des liens en masse ont perdu énormément de places dans les résultats de recherche. Du coup, il a fallu revoir les règles du jeu.

Aujourd'hui, si l'on veut offrir un référencement efficace à nos clients, il n'est plus question de mettre en place de telles pratiques et d'offrir au site internet des liens par milliers tous les mois. Dorénavant, les liens doivent être créés par des humains, pour des humains et les sites ne doivent plus disposer de milliers de liens par mois mais seulement d'une dizaine de liens efficaces.

Pour offrir un référencement de qualité à l'heure actuelle, il est nécessaire de :

- Créer des liens pertinents sur les sites qui sont modérés et lus par des humains;

- Examiner chaque site sur lequel nous travaillons et toujours fournir du contenu utile au site;

- Eviter de se tourner vers la solution de facilité, c'est-à-dire de payer pour des outils qui créeront des milliers de liens (mais qui seront discrédités par Google);

- Se concentrer sur des liens durables. Ce ne sont pas les plus faciles à mettre en place mais l'effort en vaut la peine car ils ne seront jamais discrédités. Il vaut mieux prendre un peu plus de temps pour mettre un bon lien en place que de devoir revoir toute sa stratégie de référencement;

- Privilégier la qualité plutôt que la quantité. Dix liens solides et pertinents tous les mois sont préférables à mille liens douteux.

En conclusion

Bien que courte, l'histoire du référencement a déjà eu le temps de laisser quelques traces d'ombres derrière elle et le spam en fait partie. Beaucoup de clients ont eu de mauvais échos suite à ces pratiques douteuses utilisées dans le passé par certaines agences. Dorénavant, pour se construire un nouvel héritage, il est important de privilégier les techniques de référencement pertinentes et transparentes. Entre autres choses, les liens doivent aujourd'hui être éthiques, durables et efficaces. Même si certains continuent à proposer des liens spams, il faut espérer que le monde du référencement se tourne définitivement vers le « white hat ».

Source : Searchenginewatch

Crédit : 6buzz.com

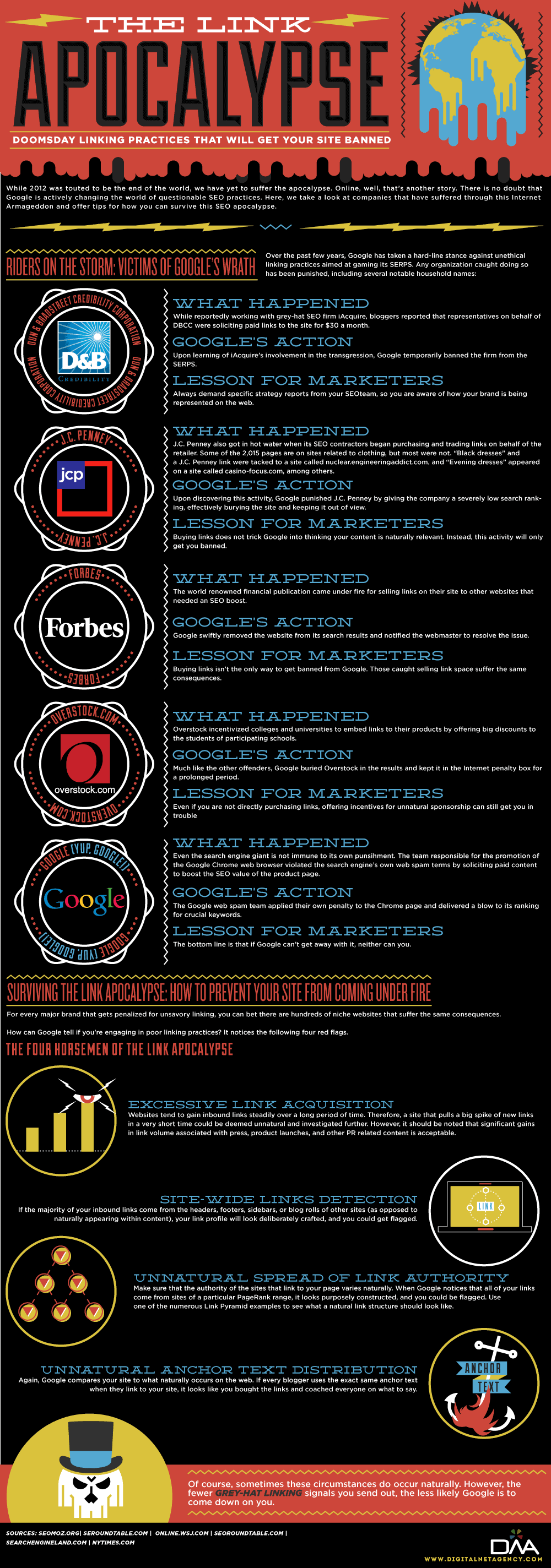

Depuis quelques années, Google met à jour des algorithmes qui peuvent faire mal à un site internet et à son référencement. Avoir un bon link building est important lorsque l'on veut gagner en visibilité. Mais attention à ne pas commettre d'erreurs pour ne pas connaitre les foudres de Penguin ou de Panda.

Pour éviter que votre site ne perde complètement sa visibilité et pour vous empêcher d'aller trop loin dans le link building, les gens de Digitalnetagency ont créé une infographie (« The Link Apocalypse ») reprenant les erreurs récentes qui ont été faites par quelques entreprises (dont Google himself !).

Voici donc les quelques erreurs à ne pas reproduire :

Via Searchengineland